Giới thiệu

Chủ đề về trí tuệ nhân tạo (AI) và việc phát hiện thông tin sai lệch trên mạng đang trở thành một trong những đề tài nóng hổi và xuất hiện ngày càng nhiều trong kỳ thi IELTS Reading. Với sự bùng nổ của công nghệ và mạng xã hội, khả năng phân biệt thông tin chính xác và giả mạo trở nên cực kỳ quan trọng, khiến chủ đề này trở thành lựa chọn ưa thích của ban giám khảo IELTS.

Trong bài viết này, bạn sẽ được trải nghiệm một bộ đề thi IELTS Reading hoàn chỉnh với 3 passages có độ khó tăng dần từ Easy đến Hard, phù hợp cho học viên từ band 5.0 trở lên. Bạn sẽ học được cách xử lý đa dạng các dạng câu hỏi phổ biến, làm quen với từ vựng học thuật liên quan đến công nghệ và truyền thông, đồng thời nắm vững các kỹ thuật làm bài hiệu quả. Đặc biệt, mỗi câu hỏi đều có đáp án chi tiết kèm giải thích cụ thể về vị trí thông tin và cách paraphrase, giúp bạn hiểu rõ phương pháp tư duy của đề thi thực tế. Đây là tài liệu lý tưởng để bạn rèn luyện kỹ năng đọc hiểu và chuẩn bị tốt nhất cho kỳ thi IELTS sắp tới.

Hướng Dẫn Làm Bài IELTS Reading

Tổng Quan Về IELTS Reading Test

IELTS Reading Test kéo dài 60 phút với 3 passages và tổng cộng 40 câu hỏi. Mỗi passage có độ dài khoảng 750-950 từ và độ khó tăng dần. Điểm số được tính dựa trên số câu trả lời đúng, không bị trừ điểm với câu sai.

Phân bổ thời gian khuyến nghị cho đề thi này:

- Passage 1: 15-17 phút (13 câu hỏi – độ khó Easy)

- Passage 2: 18-20 phút (13 câu hỏi – độ khó Medium)

- Passage 3: 23-25 phút (14 câu hỏi – độ khó Hard)

Đừng quên dành 2-3 phút cuối để chuyển đáp án vào Answer Sheet một cách cẩn thận.

Các Dạng Câu Hỏi Trong Đề Này

Đề thi mẫu này bao gồm 7 dạng câu hỏi phổ biến nhất trong IELTS Reading:

- Multiple Choice – Lựa chọn đáp án đúng từ các phương án cho sẵn

- True/False/Not Given – Xác định thông tin đúng, sai hoặc không được đề cập

- Matching Information – Nối thông tin với đoạn văn tương ứng

- Yes/No/Not Given – Xác định ý kiến của tác giả

- Matching Headings – Chọn tiêu đề phù hợp cho từng đoạn

- Summary Completion – Hoàn thành đoạn tóm tắt

- Matching Features – Nối đặc điểm với đối tượng tương ứng

IELTS Reading Practice Test

PASSAGE 1 – The Rise of AI Detection Systems

Độ khó: Easy (Band 5.0-6.5)

Thời gian đề xuất: 15-17 phút

In recent years, the proliferation of misinformation on the internet has become a pressing concern for governments, technology companies, and everyday users alike. False information spreads rapidly across social media platforms, often reaching millions of people before it can be verified or corrected. This phenomenon has serious implications for public opinion, democratic processes, and even public health, as seen during the COVID-19 pandemic when inaccurate medical advice circulated widely online.

Artificial Intelligence (AI) has emerged as a promising solution to this growing problem. Machine learning algorithms can be trained to identify patterns and characteristics common to fake news and misleading content. These systems work by analyzing various features of online content, including the language used, the source of information, user engagement patterns, and the speed of dissemination. Unlike human fact-checkers, who can only review a limited number of articles per day, AI systems can process thousands of pieces of content simultaneously, making them far more efficient at scale.

One of the earliest applications of AI in this field was the development of spam filters for email. These systems learned to recognize the characteristics of unwanted messages and automatically move them to spam folders. Today’s misinformation detection systems operate on similar principles but are far more sophisticated. They use natural language processing (NLP) to understand the context and meaning of text, not just identify keywords. This allows them to detect subtle forms of manipulation, such as when true information is presented in a misleading context or when headlines do not match the actual content of articles.

Social media companies have been at the forefront of implementing these technologies. Facebook, now known as Meta, employs AI systems that flag potentially false content for review by human fact-checkers. Twitter uses machine learning to identify coordinated inauthentic behavior, where multiple fake accounts work together to spread misinformation. YouTube’s algorithms attempt to promote authoritative sources for news-related content while reducing the visibility of videos containing conspiracy theories or unverified claims.

However, the effectiveness of these systems varies considerably. Research conducted by the Massachusetts Institute of Technology found that AI detection tools achieved accuracy rates between 65% and 85%, depending on the type of misinformation being identified. Political misinformation tends to be easier to detect than health-related false claims, partly because political content often comes from known unreliable sources, whereas health misinformation may mix accurate scientific information with false conclusions.

The implementation of AI detection systems is not without challenges. One significant issue is the “false positive” problem – when legitimate content is incorrectly flagged as misinformation. This can lead to censorship concerns, particularly when the systems misinterpret satire, parody, or legitimate controversial opinions as false information. In 2020, several credible news articles about COVID-19 were temporarily removed from social media platforms by overzealous AI systems, highlighting the risks of automated content moderation.

Another challenge lies in the constantly evolving nature of misinformation. Those who create and spread false information continuously adapt their strategies to evade detection. They may use image-based posts instead of text, subtle language variations, or cross-platform coordination that makes patterns harder for AI to recognize. This creates an ongoing arms race between detection technologies and misinformation tactics.

Despite these limitations, experts generally agree that AI represents an indispensable tool in the fight against online misinformation. The sheer volume of content uploaded to the internet every minute – estimated at over 500 hours of video to YouTube alone – makes human-only approaches impractical. The key lies not in replacing human judgment entirely but in using AI to prioritize content for human review, allowing fact-checkers to focus their efforts where they are most needed.

Questions 1-5: Multiple Choice

Choose the correct letter, A, B, C, or D.

-

According to the passage, what makes AI systems more effective than human fact-checkers?

A) They are more accurate

B) They can process more content at once

C) They never make mistakes

D) They understand context better -

The passage suggests that early spam filters for email were:

A) completely different from modern misinformation detection

B) ineffective at identifying unwanted messages

C) based on similar principles to current detection systems

D) more sophisticated than today’s systems -

Which type of misinformation is reportedly easier for AI to detect?

A) Health-related false claims

B) Political misinformation

C) Satirical content

D) Image-based posts -

What problem occurred with AI systems during the COVID-19 pandemic?

A) They failed to detect any misinformation

B) They removed some credible news articles

C) They were shut down by governments

D) They only worked on certain platforms -

The passage indicates that the best approach to combating misinformation involves:

A) using only AI systems

B) relying entirely on human fact-checkers

C) combining AI prioritization with human review

D) removing all controversial content

Questions 6-9: True/False/Not Given

Do the following statements agree with the information given in the passage?

Write:

- TRUE if the statement agrees with the information

- FALSE if the statement contradicts the information

- NOT GIVEN if there is no information on this

- Social media platforms helped misinformation spread rapidly during the COVID-19 pandemic.

- All social media companies use the same AI detection systems.

- AI detection tools achieve accuracy rates above 90% for all types of misinformation.

- People who spread misinformation change their methods to avoid AI detection.

Questions 10-13: Matching Information

Match the following statements (10-13) with the correct paragraph (A-H).

Write the correct letter, A-H.

NB: You may use any letter more than once.

A – Paragraph 1

B – Paragraph 2

C – Paragraph 3

D – Paragraph 4

E – Paragraph 5

F – Paragraph 6

G – Paragraph 7

H – Paragraph 8

- A description of how various social media platforms use AI technologies

- An explanation of why AI is necessary despite human involvement

- A mention of the serious consequences of misinformation on society

- Details about the challenges of incorrectly identifying legitimate content

PASSAGE 2 – Technical Mechanisms Behind AI Misinformation Detection

Độ khó: Medium (Band 6.0-7.5)

Thời gian đề xuất: 18-20 phút

The technical architecture underlying AI-based misinformation detection systems represents a sophisticated convergence of multiple machine learning methodologies. At the core of these systems lies natural language processing (NLP), which enables computers to analyze, understand, and generate human language in ways that were impossible just a decade ago. Modern NLP models, particularly those based on transformer architectures such as BERT (Bidirectional Encoder Representations from Transformers) and GPT (Generative Pre-trained Transformer), have revolutionized the field by achieving near-human levels of text comprehension.

Deep learning networks employed in these systems typically consist of multiple layers of artificial neurons that process information hierarchically. The initial layers might identify basic linguistic features such as word choice and sentence structure, while deeper layers recognize more abstract patterns including rhetorical strategies, emotional manipulation, and logical inconsistencies. This multi-layered approach allows the system to evaluate content from numerous perspectives simultaneously, much as a human expert would consider various dimensions of credibility when assessing information.

A critical component of effective misinformation detection is the training data used to develop these AI systems. Researchers must compile extensive datasets of both verified accurate content and confirmed misinformation, carefully labeled and categorized. This process, known as supervised learning, enables the AI to learn the distinguishing characteristics of false information. However, obtaining high-quality training data presents significant challenges. Misinformation is context-dependent; something true in one situation may be false in another. Moreover, the subjective nature of certain claims makes definitive labeling problematic, particularly for political or ideologically charged content.

Feature engineering represents another crucial aspect of these systems. Engineers identify specific indicators that might signal misinformation, including linguistic markers such as excessive use of capitalization, emotional language, absolutist terms (“always,” “never”), and the absence of nuance. Metadata features are equally important: the publication date, author credentials, website domain age, and patterns of social sharing all provide valuable clues. Research by Vosoughi and colleagues at MIT demonstrated that false stories tend to be retweeted more rapidly and reach more people than true stories, suggesting that virality patterns themselves can be diagnostic.

Graph-based analysis adds another dimension to detection capabilities. By mapping the relationships between users, accounts, and content, AI systems can identify coordinated inauthentic behavior – networks of accounts working together to amplify certain messages. These social network graphs reveal patterns invisible when examining individual posts in isolation. For instance, a sudden surge in shares from newly created accounts with few followers might indicate a coordinated campaign rather than organic interest.

Multimodal analysis, which examines both text and images together, has become increasingly important as malicious actors have adapted their strategies. A common tactic involves pairing legitimate photographs with false captions, or vice versa. Advanced AI systems now employ computer vision algorithms alongside NLP to cross-reference images with existing databases, identify manipulated photos, and assess whether visual content matches textual claims. Reverse image search capabilities enable systems to track when old photos are repurposed in new, misleading contexts.

Despite these technological advances, several fundamental limitations persist. AI systems struggle with understanding cultural context, sarcasm, irony, and implicit meanings that humans grasp intuitively. A statement that appears straightforward might carry different connotations in different cultural or linguistic communities. Additionally, AI systems can perpetuate and even amplify existing biases present in their training data. If the training dataset disproportionately labels content from certain sources or perspectives as misinformation, the AI will learn these biases, potentially leading to systematic discrimination against particular viewpoints or communities.

The adversarial nature of misinformation detection creates a unique challenge often described as a “cat and mouse game.” As AI systems improve, so do the techniques of those creating false content. Adversarial attacks on AI systems involve deliberately crafting content designed to evade detection – perhaps by using synonym substitution, paraphrasing, or embedding misleading information within otherwise factual content. Some sophisticated misinformation campaigns employ their own AI tools to generate content that appears more credible or to test messages against detection systems before widespread dissemination.

Explainability remains a significant concern in deploying these systems at scale. Many advanced AI models function as “black boxes” – they produce results without providing clear explanations of their reasoning. When a system flags content as potential misinformation, users, platforms, and regulators need to understand why. This requirement has driven research into interpretable AI methods that can articulate the specific features or patterns that triggered a classification, enabling human reviewers to make informed final decisions and helping to build trust in the system’s recommendations.

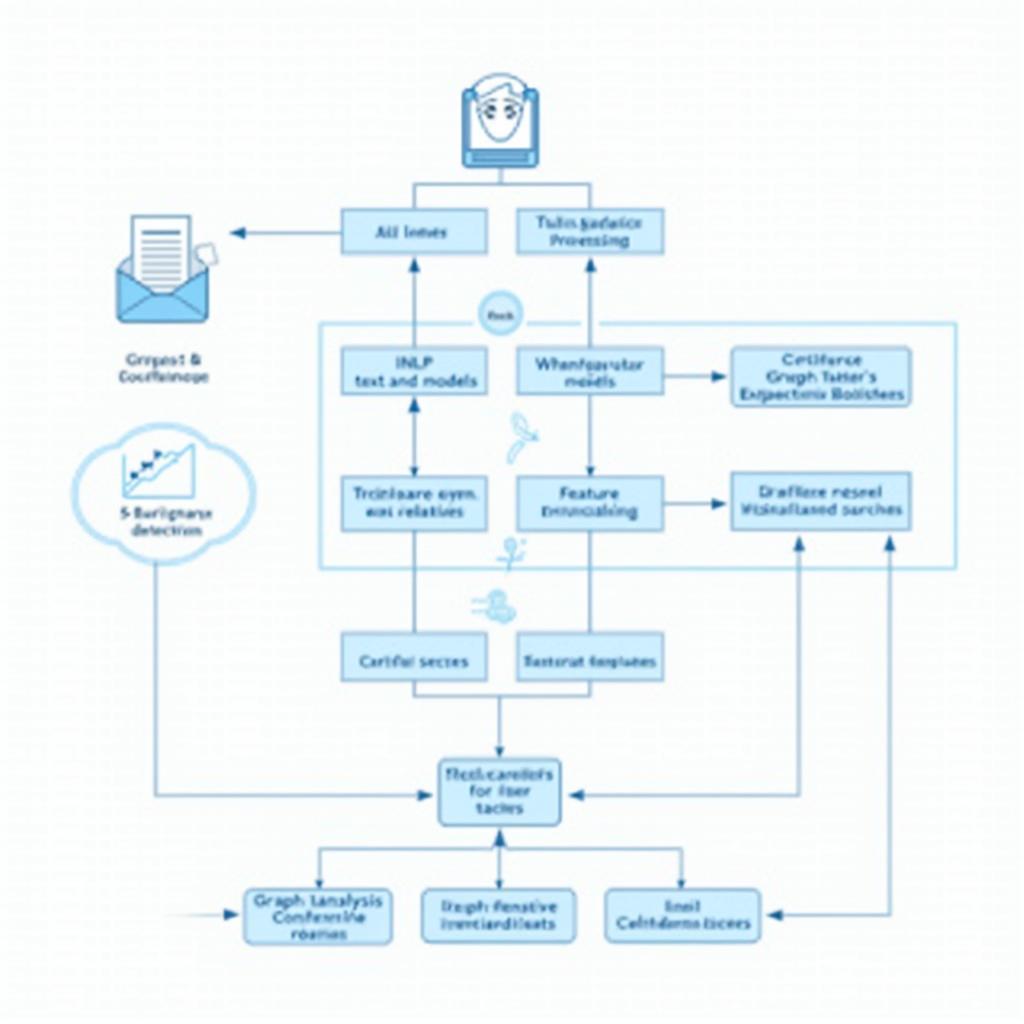

Sơ đồ kiến trúc hệ thống AI phát hiện thông tin sai lệch trực tuyến với các lớp xử lý dữ liệu

Sơ đồ kiến trúc hệ thống AI phát hiện thông tin sai lệch trực tuyến với các lớp xử lý dữ liệu

Questions 14-18: Yes/No/Not Given

Do the following statements agree with the views of the writer in the passage?

Write:

- YES if the statement agrees with the views of the writer

- NO if the statement contradicts the views of the writer

- NOT GIVEN if it is impossible to say what the writer thinks about this

- Modern NLP models can understand language as well as humans in all contexts.

- Training data for AI misinformation detection is difficult to obtain and label accurately.

- False stories spread more quickly on social media than true stories.

- All social media companies should be required by law to use AI detection systems.

- The adversarial nature of misinformation means detection methods must constantly evolve.

Questions 19-23: Matching Headings

Choose the correct heading for each section from the list of headings below.

Write the correct number, i-x.

List of Headings:

i. The role of visual content analysis in detection systems

ii. Why transparency in AI decision-making matters

iii. How basic linguistic patterns reveal false information

iv. The foundation of modern language understanding technology

v. Identifying coordinated campaigns through relationship mapping

vi. The ongoing battle between creators and detectors

vii. Problems with cultural understanding and fairness

viii. The challenge of collecting appropriate training materials

ix. Processing information through multiple analytical levels

x. Statistical indicators that distinguish false from true content

- Paragraph 2

- Paragraph 3

- Paragraph 5

- Paragraph 7

- Paragraph 9

Questions 24-26: Summary Completion

Complete the summary below using words from the box.

Write the correct letter, A-L.

Word Box:

A) virality

B) credentials

C) photographs

D) manipulation

E) emotions

F) capitalization

G) metadata

H) accuracy

I) sources

J) sharing

K) language

L) domains

Feature engineering in AI detection systems involves identifying specific indicators of misinformation. These include linguistic markers such as excessive 24)__ and highly emotional 25)__. Additionally, 26)__ features like author credentials and website information provide important contextual clues about content reliability.

PASSAGE 3 – Societal and Ethical Implications of AI-Driven Content Moderation

Độ khó: Hard (Band 7.0-9.0)

Thời gian đề xuất: 23-25 phút

The deployment of artificial intelligence systems for detecting and moderating online misinformation represents a paradigmatic shift in how societies regulate information flows, raising profound questions about the balance between combating harmful falsehoods and preserving fundamental liberties. While the technical capabilities of these systems continue to advance, their implementation occurs within complex socio-political contexts where competing values – truth, freedom of expression, privacy, transparency, and accountability – often exist in tension. The ramifications extend far beyond mere technological considerations, touching upon the very foundations of democratic discourse and the architecture of public knowledge.

The concentration of content moderation power in the hands of a few large technology corporations presents what some scholars have termed a “private governance” dilemma. Unlike traditional state censorship, which is subject to constitutional constraints and democratic accountability mechanisms, decisions made by platform algorithms often lack meaningful oversight or appeal processes. When an AI system flags content as misinformation, the criteria and reasoning may be opaque not only to users but sometimes even to the platforms themselves, particularly when using complex neural networks. This opacity creates asymmetrical power relationships where individuals have limited capacity to contest decisions that might significantly impact their ability to communicate or access information.

Epistemological concerns emerge when considering who determines truth in contested domains. While certain facts are objectively verifiable – such as dates, statistics from reliable sources, or scientific consensus on established phenomena – many claims exist in gray areas where evidence is ambiguous, incomplete, or subject to legitimate interpretation. AI systems, by necessity, must operate within frameworks that categorize content as true, false, or somewhere between. These categorizations, however, inevitably reflect particular epistemological assumptions and value judgments embedded during the system design and training phases. The question of whose conception of truth these systems encode becomes particularly acute when dealing with culturally specific knowledge, emerging scientific debates, or politically contentious assertions where multiple narratives contain elements of validity.

The differential impact of AI content moderation across demographic and linguistic communities raises significant equity concerns. Research has consistently demonstrated that these systems perform less accurately for minority languages, cultural contexts, and communities underrepresented in training data. A study by Sap and colleagues found that African American English was more likely to be flagged as potentially offensive or problematic compared to Standard American English, even when expressing identical sentiments. This systematic bias means that marginalized communities face disproportionate censorship risks, potentially silencing voices already underrepresented in mainstream discourse. Furthermore, what constitutes misinformation may itself be culturally contingent; traditional knowledge systems, indigenous cosmologies, or alternative medicine practices might be incorrectly categorized as false information when evaluated through narrow Western scientific frameworks.

The psychological and social consequences of widespread AI moderation deserve careful consideration. The knowledge that content is being continuously monitored and algorithmically judged may create “chilling effects” where individuals self-censor, avoiding controversial topics or unconventional opinions for fear of being flagged, even when their contributions would be legitimate and valuable. This phenomenon could diminish the diversity of perspectives in online spaces, creating echo chambers that reinforce dominant viewpoints while suppressing dissent and innovation. The participatory nature of digital democracy relies on citizens feeling empowered to voice opinions, challenge orthodoxies, and engage in robust debate – all activities that might be inadvertently discouraged by overzealous moderation systems.

Regulatory frameworks have begun to emerge attempting to govern these technologies, though approaches vary significantly across jurisdictions. The European Union’s Digital Services Act mandates greater transparency from platforms regarding their content moderation practices and establishes mechanisms for users to challenge decisions. Singapore’s Protection from Online Falsehoods and Manipulation Act grants government authorities explicit power to order corrections or removal of content deemed false, with platforms required to comply or face penalties – an approach that has drawn criticism from civil liberties advocates who warn of state overreach. The United States, conversely, has generally maintained a more hands-off approach, with Section 230 of the Communications Decency Act providing platforms broad immunity for content moderation decisions, though this protection faces increasing political pressure from multiple directions.

The economic dimensions of AI-driven misinformation detection also warrant scrutiny. Developing sophisticated detection systems requires substantial investment in research, computational infrastructure, and human expertise – resources primarily available to wealthy corporations and well-funded institutions. This resource asymmetry could exacerbate existing digital divides, with smaller platforms, local news organizations, and civil society groups in developing countries unable to implement comparable safeguards. The commodification of trust-related technologies may create market dynamics where only those who can afford premium verification services receive algorithmic benefits, potentially creating a two-tiered information ecosystem divided along economic lines.

Long-term trajectories suggest several possible futures for these technologies. Optimistic scenarios envision collaborative ecosystems where open-source detection tools, transparent algorithms, and multi-stakeholder governance enable effective misinformation mitigation while safeguarding rights. In such futures, AI serves as an empowering tool that enhances rather than replaces human critical thinking, with educational initiatives helping citizens develop media literacy skills that complement technological safeguards. Pessimistic projections, however, warn of surveillance capitalism intensifying, with ever-more sophisticated systems creating comprehensive profiles of ideological tendencies, manipulating information exposure to serve corporate or state interests, and normalizing algorithmic authority over human judgment in determining acceptable discourse.

The path forward requires multidisciplinary dialogue among technologists, policymakers, ethicists, social scientists, and affected communities. Technical solutions alone cannot address fundamentally social problems; the challenge of misinformation reflects deeper issues of declining institutional trust, political polarization, educational deficits, and economic anxieties that make populations susceptible to false narratives. Sustainable approaches must therefore combine intelligent technology deployment with investments in quality journalism, civic education, platform accountability mechanisms, and social policies that address the underlying conditions making misinformation persuasive and powerful. Only through such holistic strategies can societies hope to navigate the complex tensions between truth and freedom that define the digital age.

Minh họa tác động xã hội và đạo đức của hệ thống kiểm duyệt nội dung AI trên các cộng đồng khác nhau

Minh họa tác động xã hội và đạo đức của hệ thống kiểm duyệt nội dung AI trên các cộng đồng khác nhau

Questions 27-31: Multiple Choice

Choose the correct letter, A, B, C, or D.

-

According to the passage, what is the main difference between AI content moderation and traditional state censorship?

A) AI systems are more accurate than government censors

B) Traditional censorship has democratic accountability mechanisms

C) State censorship is always more severe than AI moderation

D) AI systems are subject to constitutional constraints -

The passage suggests that epistemological concerns arise because:

A) AI systems cannot verify any facts objectively

B) all information exists in gray areas without clear truth

C) determining truth in contested domains involves subjective judgments

D) technology companies deliberately promote false information -

Research on African American English mentioned in the passage demonstrates:

A) that this dialect is inherently more offensive

B) systematic bias in AI content moderation systems

C) that minority languages cannot be accurately processed

D) cultural differences in how people express sentiments -

The “chilling effect” described in the passage refers to:

A) the cooling systems required for AI computers

B) people avoiding controversial topics due to monitoring

C) declining temperatures in online discussions

D) freezing accounts that spread misinformation -

Which regulatory approach does the passage associate with the European Union?

A) Granting government authorities power to order content removal

B) Providing platforms broad immunity for moderation decisions

C) Banning all forms of AI content moderation

D) Mandating transparency and establishing appeal mechanisms

Questions 32-36: Matching Features

Match each concern (32-36) with the correct domain (A-F) it primarily relates to.

Write the correct letter, A-F.

Domains:

A) Technical capabilities

B) Economic factors

C) Psychological effects

D) Cultural equity

E) Political governance

F) Epistemological questions

- Resource asymmetry between wealthy corporations and smaller organizations

- Traditional knowledge systems being incorrectly categorized as false

- Individuals self-censoring to avoid being flagged by algorithms

- Determining whose conception of truth is encoded in systems

- Differences in regulatory frameworks across jurisdictions

Questions 37-40: Short Answer Questions

Answer the questions below using NO MORE THAN THREE WORDS from the passage for each answer.

-

What type of “dilemma” do scholars associate with concentrated content moderation power in technology companies?

-

According to the passage, what kind of effects might cause people to avoid expressing unconventional opinions online?

-

What section of US law provides platforms with immunity for content moderation decisions?

-

What must be combined with technical solutions to address the fundamental social problems underlying misinformation?

Answer Keys – Đáp Án

PASSAGE 1: Questions 1-13

- B

- C

- B

- B

- C

- TRUE

- NOT GIVEN

- FALSE

- TRUE

- D

- H

- A

- F

PASSAGE 2: Questions 14-26

- NO

- YES

- YES

- NOT GIVEN

- YES

- ix

- viii

- v

- vii

- ii

- F

- K

- G

PASSAGE 3: Questions 27-40

- B

- C

- B

- B

- D

- B

- D

- C

- F

- E

- private governance

- chilling effects

- Section 230

- multidisciplinary dialogue

Giải Thích Đáp Án Chi Tiết

Passage 1 – Giải Thích

Câu 1: B

- Dạng câu hỏi: Multiple Choice

- Từ khóa: AI systems, more effective, human fact-checkers

- Vị trí trong bài: Đoạn 2, dòng 4-7

- Giải thích: Bài đọc nói rõ “Unlike human fact-checkers, who can only review a limited number of articles per day, AI systems can process thousands of pieces of content simultaneously”. Đây là paraphrase của đáp án B “They can process more content at once”. Các đáp án khác không được nhắc đến hoặc sai với nội dung bài.

Câu 2: C

- Dạng câu hỏi: Multiple Choice

- Từ khóa: early spam filters, email

- Vị trí trong bài: Đoạn 3, dòng 1-3

- Giải thích: Câu trong bài viết “Today’s misinformation detection systems operate on similar principles but are far more sophisticated” cho thấy các hệ thống hiện đại hoạt động dựa trên nguyên lý tương tự spam filters, chính là đáp án C.

Câu 3: B

- Dạng câu hỏi: Multiple Choice

- Từ khóa: type of misinformation, easier, AI, detect

- Vị trí trong bài: Đoạn 5, dòng 3-5

- Giải thích: “Political misinformation tends to be easier to detect than health-related false claims” – đây là câu trích dẫn trực tiếp từ bài, khớp hoàn toàn với đáp án B.

Câu 4: B

- Dạng câu hỏi: Multiple Choice

- Từ khóa: problem, AI systems, COVID-19

- Vị trí trong bài: Đoạn 6, dòng 4-6

- Giải thích: Bài đọc đề cập “In 2020, several credible news articles about COVID-19 were temporarily removed from social media platforms by overzealous AI systems”, paraphrase của “removed some credible news articles” là đáp án B.

Câu 5: C

- Dạng câu hỏi: Multiple Choice

- Từ khóa: best approach, combating misinformation

- Vị trí trong bài: Đoạn 8, dòng 3-6

- Giải thích: Đoạn cuối nói “The key lies not in replacing human judgment entirely but in using AI to prioritize content for human review”, khớp với đáp án C về việc kết hợp AI với human review.

Câu 6: TRUE

- Dạng câu hỏi: True/False/Not Given

- Từ khóa: social media platforms, misinformation, COVID-19

- Vị trí trong bài: Đoạn 1, dòng 4-6

- Giải thích: Bài viết nhắc đến misinformation có “serious implications” trong COVID-19 pandemic khi “inaccurate medical advice circulated widely online”, xác nhận vai trò của social media trong việc lan truyền.

Câu 7: NOT GIVEN

- Dạng câu hỏi: True/False/Not Given

- Từ khóa: all social media companies, same AI detection systems

- Vị trí trong bài: Không có thông tin

- Giải thích: Mặc dù đoạn 4 đề cập các công ty khác nhau sử dụng AI, nhưng không nói họ dùng cùng một hệ thống hay khác nhau.

Câu 8: FALSE

- Dạng câu hỏi: True/False/Not Given

- Từ khóa: accuracy rates, above 90%

- Vị trí trong bài: Đoạn 5, dòng 1-3

- Giải thích: Bài viết nói rõ “AI detection tools achieved accuracy rates between 65% and 85%”, mâu thuẫn với phát biểu “above 90%”.

Câu 9: TRUE

- Dạng câu hỏi: True/False/Not Given

- Từ khóa: people, spread misinformation, change methods, avoid detection

- Vị trí trong bài: Đoạn 7, dòng 1-3

- Giải thích: “Those who create and spread false information continuously adapt their strategies to evade detection” – khớp hoàn toàn với nội dung câu hỏi.

Câu 10: D

- Dạng câu hỏi: Matching Information

- Giải thích: Đoạn 4 (D) mô tả cách Facebook, Twitter, và YouTube sử dụng các công nghệ AI khác nhau.

Câu 11: H

- Dạng câu hỏi: Matching Information

- Giải thích: Đoạn 8 (H) giải thích tại sao AI cần thiết do khối lượng nội dung khổng lồ, dù vẫn cần con người.

Câu 12: A

- Dạng câu hỏi: Matching Information

- Giải thích: Đoạn 1 (A) đề cập các hậu quả nghiêm trọng của misinformation đối với xã hội, dân chủ và sức khỏe cộng đồng.

Câu 13: F

- Dạng câu hỏi: Matching Information

- Giải thích: Đoạn 6 (F) thảo luận về “false positive problem” – khi nội dung hợp lệ bị gắn cờ nhầm.

Passage 2 – Giải Thích

Câu 14: NO

- Dạng câu hỏi: Yes/No/Not Given

- Từ khóa: Modern NLP models, understand language, as well as humans, all contexts

- Vị trí trong bài: Đoạn 1, dòng 5-7

- Giải thích: Bài viết nói NLP đạt “near-human levels of text comprehension” nhưng đoạn 7 lại chỉ ra AI vẫn gặp khó khăn với “cultural context, sarcasm, irony” – điều này cho thấy chưa bằng con người trong mọi ngữ cảnh.

Câu 15: YES

- Dạng câu hỏi: Yes/No/Not Given

- Từ khóa: Training data, difficult, obtain, label

- Vị trí trong bài: Đoạn 3, dòng 4-8

- Giải thích: “Obtaining high-quality training data presents significant challenges” và “the subjective nature of certain claims makes definitive labeling problematic” – khớp với quan điểm của tác giả.

Câu 16: YES

- Dạng câu hỏi: Yes/No/Not Given

- Từ khóa: false stories, spread more quickly, true stories

- Vị trí trong bài: Đoạn 4, dòng 5-7

- Giải thích: “Research by Vosoughi and colleagues at MIT demonstrated that false stories tend to be retweeted more rapidly and reach more people than true stories” – tác giả trích dẫn nghiên cứu để hỗ trợ quan điểm này.

Câu 17: NOT GIVEN

- Dạng câu hỏi: Yes/No/Not Given

- Từ khóa: social media companies, required by law, use AI

- Vị trí trong bài: Không có thông tin

- Giải thích: Bài viết không đề cập đến việc có nên bắt buộc bằng luật hay không, chỉ mô tả hiện trạng sử dụng.

Câu 18: YES

- Dạng câu hỏi: Yes/No/Not Given

- Từ khóa: adversarial nature, detection methods, constantly evolve

- Vị trí trong bài: Đoạn 8, dòng 1-3

- Giải thích: Tác giả mô tả “cat and mouse game” và “As AI systems improve, so do the techniques” – thể hiện sự đồng ý với quan điểm này.

Câu 19: ix

- Dạng câu hỏi: Matching Headings

- Giải thích: Đoạn 2 mô tả cách deep learning networks xử lý thông tin qua nhiều lớp, từ cơ bản đến trừu tượng – khớp với heading “Processing information through multiple analytical levels”.

Câu 20: viii

- Dạng câu hỏi: Matching Headings

- Giải thích: Đoạn 3 tập trung vào thách thức của training data, việc compile datasets và labeling – tương ứng “The challenge of collecting appropriate training materials”.

Câu 21: v

- Dạng câu hỏi: Matching Headings

- Giải thích: Đoạn 5 nói về graph-based analysis để phát hiện coordinated behavior thông qua social network graphs – đúng với “Identifying coordinated campaigns through relationship mapping”.

Câu 22: vii

- Dạng câu hỏi: Matching Headings

- Giải thích: Đoạn 7 thảo luận về limitations của AI với cultural context và biases – khớp “Problems with cultural understanding and fairness”.

Câu 23: ii

- Dạng câu hỏi: Matching Headings

- Giải thích: Đoạn 9 đề cập explainability concerns và việc systems cần articulate reasoning – tương ứng “Why transparency in AI decision-making matters”.

Câu 24: F (capitalization)

- Dạng câu hỏi: Summary Completion

- Vị trí trong bài: Đoạn 4, dòng 2

- Giải thích: “excessive use of capitalization” – từ trong bài.

Câu 25: K (language)

- Dạng câu hỏi: Summary Completion

- Vị trí trong bài: Đoạn 4, dòng 2

- Giải thích: “emotional language” – từ trong bài.

Câu 26: G (metadata)

- Dạng câu hỏi: Summary Completion

- Vị trí trong bài: Đoạn 4, dòng 3

- Giải thích: “Metadata features are equally important” – từ trong bài.

Passage 3 – Giải Thích

Câu 27: B

- Dạng câu hỏi: Multiple Choice

- Từ khóa: main difference, AI content moderation, traditional state censorship

- Vị trí trong bài: Đoạn 2, dòng 2-4

- Giải thích: “Unlike traditional state censorship, which is subject to constitutional constraints and democratic accountability mechanisms, decisions made by platform algorithms often lack meaningful oversight” – đáp án B chính xác.

Câu 28: C

- Dạng câu hỏi: Multiple Choice

- Từ khóa: epistemological concerns arise

- Vị trí trong bài: Đoạn 3, dòng 1-6

- Giải thích: Bài viết nói “many claims exist in gray areas” và categorizations “inevitably reflect particular epistemological assumptions and value judgments” – tức là có subjective judgments, đáp án C.

Câu 29: B

- Dạng câu hỏi: Multiple Choice

- Từ khóa: African American English, demonstrates

- Vị trí trong bài: Đoạn 4, dòng 3-6

- Giải thích: Nghiên cứu cho thấy African American English “more likely to be flagged” và đây là “systematic bias”, chính là đáp án B.

Câu 30: B

- Dạng câu hỏi: Multiple Choice

- Từ khóa: chilling effect, refers to

- Vị trí trong bài: Đoạn 5, dòng 2-4

- Giải thích: “Individuals self-censor, avoiding controversial topics or unconventional opinions for fear of being flagged” – định nghĩa rõ ràng về chilling effect là đáp án B.

Câu 31: D

- Dạng câu hỏi: Multiple Choice

- Từ khóa: regulatory approach, European Union

- Vị trí trong bài: Đoạn 6, dòng 2-4

- Giải thích: “The European Union’s Digital Services Act mandates greater transparency… and establishes mechanisms for users to challenge decisions” – đúng với đáp án D.

Câu 32: B (Economic factors)

- Dạng câu hỏi: Matching Features

- Vị trí trong bài: Đoạn 7, dòng 2-4

- Giải thích: “Resource asymmetry” được thảo luận trong đoạn về economic dimensions.

Câu 33: D (Cultural equity)

- Dạng câu hỏi: Matching Features

- Vị trí trong bài: Đoạn 4, dòng 7-10

- Giải thích: Traditional knowledge systems là vấn đề cultural equity được đề cập trong đoạn về differential impact.

Câu 34: C (Psychological effects)

- Dạng câu hỏi: Matching Features

- Vị trí trong bài: Đoạn 5, dòng 2-4

- Giải thích: Self-censoring là psychological effect được mô tả trong đoạn về consequences.

Câu 35: F (Epistemological questions)

- Dạng câu hỏi: Matching Features

- Vị trí trong bài: Đoạn 3, dòng 6-8

- Giải thích: “Whose conception of truth” là epistemological question trung tâm của đoạn 3.

Câu 36: E (Political governance)

- Dạng câu hỏi: Matching Features

- Vị trí trong bài: Đoạn 6

- Giải thích: Regulatory frameworks across jurisdictions là chủ đề governance.

Câu 37: private governance

- Dạng câu hỏi: Short Answer

- Vị trí trong bài: Đoạn 2, dòng 1

- Giải thích: “What some scholars have termed a ‘private governance’ dilemma” – trích dẫn trực tiếp.

Câu 38: chilling effects

- Dạng câu hỏi: Short Answer

- Vị trí trong bài: Đoạn 5, dòng 2

- Giải thích: “May create ‘chilling effects'” – thuật ngữ trong bài.

Câu 39: Section 230

- Dạng câu hỏi: Short Answer

- Vị trí trong bài: Đoạn 6, dòng 6-7

- Giải thích: “Section 230 of the Communications Decency Act providing platforms broad immunity” – chính xác ba từ.

Câu 40: multidisciplinary dialogue

- Dạng câu hỏi: Short Answer

- Vị trí trong bài: Đoạn 9, dòng 1

- Giải thích: “The path forward requires multidisciplinary dialogue” – đúng ba từ và là yếu tố cần kết hợp với technical solutions.

Từ Vựng Quan Trọng Theo Passage

Passage 1 – Essential Vocabulary

| Từ vựng | Loại từ | Phiên âm | Nghĩa tiếng Việt | Ví dụ từ bài | Collocation |

|---|---|---|---|---|---|

| proliferation | n | /prəˌlɪfəˈreɪʃn/ | sự gia tăng nhanh chóng | the proliferation of misinformation | rapid proliferation, nuclear proliferation |

| misinformation | n | /ˌmɪsɪnfəˈmeɪʃn/ | thông tin sai lệch | spreading misinformation online | spread misinformation, combat misinformation |

| pressing concern | n phrase | /ˈpresɪŋ kənˈsɜːrn/ | mối quan ngại cấp bách | has become a pressing concern | address pressing concerns |

| verify | v | /ˈverɪfaɪ/ | xác minh | before it can be verified | verify information, verify facts |

| implications | n | /ˌɪmplɪˈkeɪʃnz/ | những hệ quả, tác động | serious implications for public health | have implications, political implications |

| algorithm | n | /ˈælɡərɪðəm/ | thuật toán | machine learning algorithms | complex algorithm, search algorithm |

| dissemination | n | /dɪˌsemɪˈneɪʃn/ | sự lan truyền | speed of dissemination | information dissemination, widespread dissemination |

| sophisticated | adj | /səˈfɪstɪkeɪtɪd/ | tinh vi, phức tạp | far more sophisticated | highly sophisticated, sophisticated technology |

| manipulate | v | /məˈnɪpjuleɪt/ | thao túng | subtle forms of manipulation | manipulate data, easily manipulated |

| flag | v | /flæɡ/ | đánh dấu, gắn cờ | flag potentially false content | flag content, flag for review |

| accuracy | n | /ˈækjərəsi/ | độ chính xác | accuracy rates between 65% and 85% | high accuracy, improve accuracy |

| evolve | v | /iˈvɒlv/ | phát triển, tiến hóa | constantly evolving nature | continuously evolve, rapidly evolving |

Passage 2 – Essential Vocabulary

| Từ vựng | Loại từ | Phiên âm | Nghĩa tiếng Việt | Ví dụ từ bài | Collocation |

|---|---|---|---|---|---|

| architecture | n | /ˈɑːrkɪtektʃər/ | kiến trúc hệ thống | technical architecture underlying | system architecture, network architecture |

| convergence | n | /kənˈvɜːrdʒəns/ | sự hội tụ | sophisticated convergence | technological convergence, convergence of ideas |

| methodology | n | /ˌmeθəˈdɒlədʒi/ | phương pháp luận | machine learning methodologies | research methodology, scientific methodology |

| transformer | n | /trænsˈfɔːrmər/ | mô hình transformer | transformer architectures | transformer model, attention-based transformer |

| hierarchically | adv | /ˌhaɪəˈrɑːrkɪkli/ | theo cấp bậc | process information hierarchically | organized hierarchically |

| supervised learning | n phrase | /ˈsuːpərvaɪzd ˈlɜːrnɪŋ/ | học có giám sát | process known as supervised learning | supervised learning algorithm |

| feature engineering | n phrase | /ˈfiːtʃər ˌendʒɪˈnɪərɪŋ/ | kỹ thuật tạo đặc trưng | feature engineering represents | advanced feature engineering |

| linguistic markers | n phrase | /lɪŋˈɡwɪstɪk ˈmɑːrkərz/ | dấu hiệu ngôn ngữ | linguistic markers such as | identify linguistic markers |

| metadata | n | /ˈmetədeɪtə/ | siêu dữ liệu | metadata features are important | extract metadata, metadata analysis |

| virality | n | /vaɪˈræləti/ | tính lan truyền | virality patterns themselves | social virality, content virality |

| graph-based analysis | n phrase | /ɡræf beɪst əˈnæləsɪs/ | phân tích dựa trên đồ thị | graph-based analysis adds dimension | network graph-based analysis |

| amplify | v | /ˈæmplɪfaɪ/ | khuếch đại | working together to amplify messages | amplify signals, amplify voices |

| multimodal | adj | /ˌmʌltiˈməʊdl/ | đa phương thức | multimodal analysis examines | multimodal learning, multimodal data |

| adversarial | adj | /ˌædvərˈseriəl/ | đối kháng | adversarial nature creates challenge | adversarial attack, adversarial training |

| explainability | n | /ɪkˌspleɪnəˈbɪləti/ | tính giải thích được | explainability remains concern | AI explainability, model explainability |

Passage 3 – Essential Vocabulary

| Từ vựng | Loại từ | Phiên âm | Nghĩa tiếng Việt | Nghĩa tiếng Việt | Ví dụ từ bài | Collocation |

|---|---|---|---|---|---|---|

| deployment | n | /dɪˈplɔɪmənt/ | sự triển khai | the deployment of AI systems | military deployment, rapid deployment | |

| paradigmatic | adj | /ˌpærədɪɡˈmætɪk/ | mang tính mô hình | paradigmatic shift in regulation | paradigmatic example, paradigmatic case | |

| ramifications | n | /ˌræmɪfɪˈkeɪʃnz/ | hệ quả, phân nhánh | the ramifications extend far beyond | serious ramifications, political ramifications | |

| governance | n | /ˈɡʌvərnəns/ | quản trị | private governance dilemma | corporate governance, good governance | |

| opacity | n | /əʊˈpæsəti/ | tính mờ đục, thiếu minh bạch | this opacity creates asymmetrical power | algorithmic opacity, institutional opacity | |

| epistemological | adj | /ɪˌpɪstəməˈlɒdʒɪkl/ | thuộc nhận thức luận | epistemological concerns emerge | epistemological framework, epistemological question | |

| contested | adj | /kənˈtestɪd/ | gây tranh cãi | in contested domains | hotly contested, contested territory | |

| ambiguous | adj | /æmˈbɪɡjuəs/ | mơ hồ | evidence is ambiguous | highly ambiguous, ambiguous statement | |

| disproportionate | adj | /ˌdɪsprəˈpɔːrʃənət/ | không cân xứng | disproportionate censorship risks | disproportionate impact, disproportionate effect | |

| marginalized | adj | /ˈmɑːrdʒɪnəlaɪzd/ | bị gạt ra lề | marginalized communities face | socially marginalized, economically marginalized | |

| chilling effect | n phrase | /ˈtʃɪlɪŋ ɪˈfekt/ | hiệu ứng tự kiểm duyệt | may create chilling effects | have a chilling effect on speech | |

| self-censor | v | /self ˈsensər/ | tự kiểm duyệt | individuals self-censor | tendency to self-censor | |

| echo chamber | n phrase | /ˈekəʊ ˌtʃeɪmbər/ | buồng vang (môi trường một chiều) | creating echo chambers | digital echo chamber, political echo chamber | |

| mandate | v | /ˈmændeɪt/ | bắt buộc, ủy nhiệm | Digital Services Act mandates | legally mandated, government-mandated | |

| jurisdiction | n | /ˌdʒʊərɪsˈdɪkʃn/ | quyền tài phán | vary across jurisdictions | legal jurisdiction, under the jurisdiction | |

| asymmetry | n | /eɪˈsɪmətri/ | sự bất cân xứng | resource asymmetry | information asymmetry, power asymmetry | |

| exacerbate | v | /ɪɡˈzæsərbeɪt/ | làm trầm trọng thêm | could exacerbate digital divides | exacerbate problems, severely exacerbate | |

| commodification | n | /kəˌmɒdɪfɪˈkeɪʃn/ | sự hàng hóa hóa | commodification of trust-related technologies | commodification of data | |

| holistic | adj | /həʊˈlɪstɪk/ | toàn diện | through holistic strategies | holistic approach, holistic view |

Kết bài

Chủ đề về trí tuệ nhân tạo trong việc phát hiện thông tin sai lệch trực tuyến không chỉ phản ánh xu hướng công nghệ đương đại mà còn là một trong những đề tài xuất hiện thường xuyên trong IELTS Reading. Bộ đề thi mẫu này đã cung cấp cho bạn trải nghiệm hoàn chỉnh với ba passages có độ khó tăng dần từ Easy đến Hard, bao quát đầy đủ các dạng câu hỏi phổ biến nhất trong kỳ thi thực tế.

Passage 1 giới thiệu các khái niệm cơ bản về AI detection systems, Passage 2 đi sâu vào các cơ chế kỹ thuật phức tạp, và Passage 3 khám phá những hệ quả xã hội và đạo đức sâu sắc của công nghệ này. Mỗi câu hỏi đều được thiết kế để rèn luyện kỹ năng đọc hiểu cụ thể, từ scanning và skimming đến inferencing và paraphrasing.

Đáp án chi tiết kèm giải thích cụ thể về vị trí thông tin và phương pháp paraphrase sẽ giúp bạn hiểu rõ cách tư duy của đề thi IELTS. Hãy dành thời gian phân tích từng câu trả lời, đặc biệt chú ý đến cách câu hỏi được diễn đạt lại so với thông tin trong bài đọc. Bảng từ vựng với hơn 40 từ học thuật quan trọng sẽ là tài sản quý giá cho việc nâng cao vốn từ của bạn.

Để đạt hiệu quả tối đa, hãy luyện tập đề này nhiều lần, mỗi lần tập trung vào một khía cạnh khác nhau: lần đầu làm trong giới hạn thời gian, lần sau phân tích kỹ thuật làm bài, lần tiếp theo học từ vựng và cấu trúc. Với sự kiên trì và phương pháp đúng đắn, bạn hoàn toàn có thể chinh phục band điểm mong muốn trong phần IELTS Reading.